L’AI Act è il primo quadro giuridico in assoluto sull’IA che affronta i rischi posti dall’intelligenza artificiale e posiziona l’Europa in pole position, permettendole di avere un ruolo di primo piano a livello globale nella formazione dei futuri scenari mondiali.

In questo articolo analizziamo il punto di vista europeo, definendo le linee guida che hanno mosso i legislatori centrali.

L’AI Act mira a fornire agli sviluppatori e agli utilizzatori dell’IA requisiti e obblighi chiari relativi agli usi specifici dell’IA. Allo stesso tempo, il regolamento mira a ridurre gli oneri amministrativi e finanziari per le imprese, in particolare per le piccole e medie imprese (PMI).

La legge sull’intelligenza artificiale fa parte di un pacchetto più ampio di misure politiche a sostegno dello sviluppo di un’intelligenza artificiale affidabile, che comprende anche il pacchetto sull’innovazione dell’intelligenza artificiale e il piano coordinato sull’intelligenza artificiale. Insieme, queste misure garantiranno la sicurezza e i diritti fondamentali delle persone e delle imprese quando si tratta di intelligenza artificiale. Rafforzeranno inoltre l’adozione, gli investimenti e l’innovazione nel campo dell’IA in tutta l’UE.

L’AI Act è il primo quadro giuridico completo sull’IA a livello mondiale. L’obiettivo delle nuove norme è promuovere un’IA affidabile in Europa e oltre, garantendo che i sistemi di IA rispettino i diritti fondamentali, la sicurezza e i principi etici e affrontando i rischi di modelli di IA molto potenti e di grande impatto.

PERCHÈ UNA LEGGE EUROPEA?

La legge sull’intelligenza artificiale garantisce che gli europei possano avere fiducia in ciò che l’intelligenza artificiale ha da offrire. Mentre la maggior parte dei sistemi di intelligenza artificiale comporta rischi limitati o nulli e può contribuire a risolvere molte sfide sociali, alcuni sistemi di intelligenza artificiale creano rischi che dobbiamo affrontare per evitare risultati indesiderati.

Ad esempio, spesso non è possibile scoprire perché un sistema di intelligenza artificiale ha preso una decisione o una previsione e ha intrapreso una determinata azione. Pertanto, potrebbe diventare difficile valutare se qualcuno è stato ingiustamente svantaggiato, ad esempio in una decisione di assunzione o in una domanda per un regime di pubblica utilità.

Sebbene la legislazione esistente offra una certa protezione, non è sufficiente per affrontare le sfide specifiche che i sistemi di intelligenza artificiale possono comportare.

Le norme proposte:

- affrontare i rischi creati specificamente dalle applicazioni di intelligenza artificiale;

- vietare le pratiche di IA che comportano rischi inaccettabili;

- determinare un elenco di applicazioni ad alto rischio;

- stabilire requisiti chiari per i sistemi di intelligenza artificiale per applicazioni ad alto rischio;

- definire obblighi specifici per gli utilizzatori e i fornitori di applicazioni IA ad alto rischio;

- richiedere una valutazione della conformità prima che un determinato sistema di IA sia messo in servizio o immesso sul mercato;

- mettere in atto l’attuazione dopo che un determinato sistema di IA è stato immesso sul mercato;

- stabilire una struttura di governance a livello europeo e nazionale.

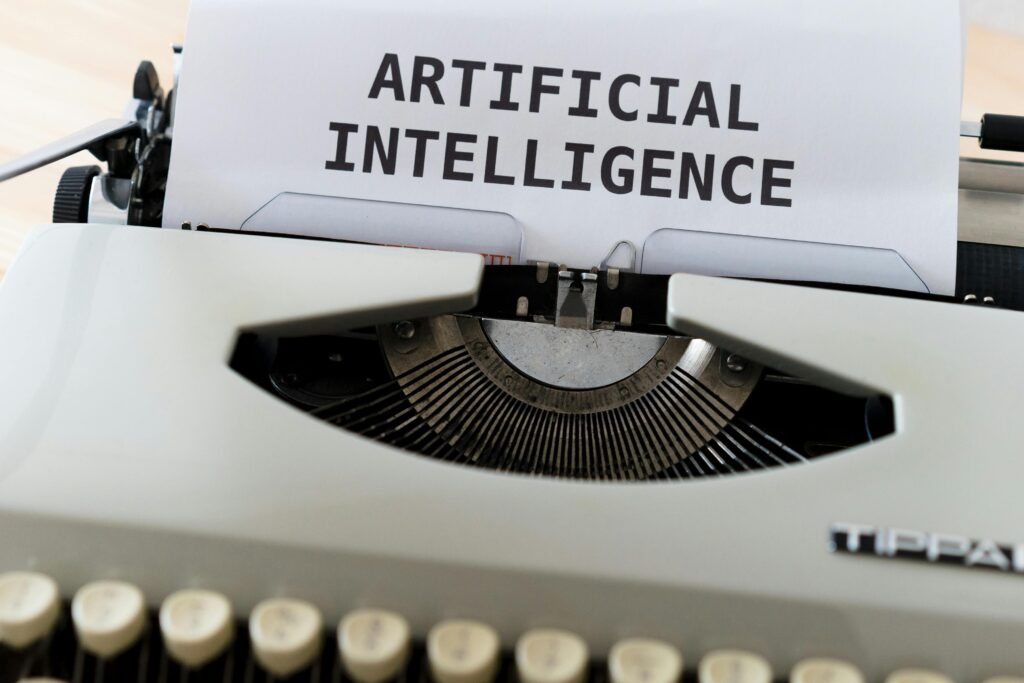

UN APPROCCIO BASATO SUL LIVELLO DI RISCHIO

Il quadro normativo definisce 4 livelli di rischio per i sistemi di IA, come rappresentati nel grafico riportato sotto.

Tutti i sistemi di intelligenza artificiale considerati una chiara minaccia alla sicurezza, ai mezzi di sussistenza e ai diritti delle persone saranno vietati, dai punteggi sociali da parte dei governi ai giocattoli che utilizzano l’assistenza vocale che incoraggia comportamenti pericolosi.

Vediamo ora quindi cosa rappresentano e quali specifiche caratteristiche hanno i diversi livelli di rischio identificati dall’Unione Europea.

AI ACT E RISCHIO ALTO

I sistemi di IA identificati come ad alto rischio includono la tecnologia AI utilizzata in:

- infrastrutture critiche (es. trasporti), che potrebbero mettere a rischio la vita e la salute dei cittadini

- formazione scolastica o professionale, che può determinare l’accesso all’istruzione e al percorso professionale della vita di qualcuno (ad esempio il punteggio degli esami)

- componenti di sicurezza dei prodotti (ad esempio applicazione dell’intelligenza artificiale nella chirurgia assistita da robot)

- assunzione, gestione dei lavoratori e accesso al lavoro autonomo (ad esempio software di smistamento dei CV per le procedure di reclutamento)

- servizi pubblici e privati essenziali (ad esempio il credit scoring che nega ai cittadini la possibilità di ottenere un prestito)

- applicazione della legge che potrebbe interferire con i diritti fondamentali delle persone (ad esempio, valutazione dell’attendibilità delle prove)

- gestione della migrazione, dell’asilo e del controllo delle frontiere (ad esempio esame automatizzato delle domande di visto)

- amministrazione della giustizia e processi democratici (ad esempio soluzioni di intelligenza artificiale per la ricerca di sentenze)

I sistemi di IA ad alto rischio saranno soggetti a obblighi rigorosi prima di poter essere immessi sul mercato:

- adeguati sistemi di valutazione e mitigazione del rischio

- alta qualità dei set di dati che alimentano il sistema per ridurre al minimo i rischi e gli esiti discriminatori

- registrazione delle attività per garantire la tracciabilità dei risultati

- documentazione dettagliata che fornisce tutte le informazioni necessarie sul sistema e sul suo scopo affinché le autorità possano valutarne la conformità

- informazioni chiare e adeguate all’operatore

- adeguate misure di supervisione umana per ridurre al minimo i rischi

- elevato livello di robustezza, sicurezza e precisione

Tutti i sistemi di identificazione biometrica remota sono considerati ad alto rischio e soggetti a requisiti rigorosi. In linea di principio è vietato l’uso dell’identificazione biometrica remota in spazi accessibili al pubblico a fini di contrasto.

Eccezioni limitate sono rigorosamente definite e regolamentate, ad esempio quando necessario per ricercare un minore scomparso, per prevenire una minaccia terroristica specifica e imminente o per individuare, localizzare, identificare o perseguire un autore o un sospettato di un reato grave.

Tali utilizzi sono soggetti all’autorizzazione di un organo giudiziario o altro organo indipendente e a limiti adeguati nel tempo, nella portata geografica e nelle banche dati consultate.

AI ACT E RISCHIO LIMITATO

Il rischio limitato si riferisce ai rischi associati alla mancanza di trasparenza nell’utilizzo dell’IA. La legge sull’intelligenza artificiale, il nostro AI Act, introduce specifici obblighi di trasparenza per garantire che gli esseri umani siano informati quando necessario, favorendo la fiducia. Ad esempio, quando si utilizzano sistemi di intelligenza artificiale come i chatbot, gli esseri umani dovrebbero essere consapevoli che stanno interagendo con una macchina in modo che possano prendere una decisione informata se continuare o fare un passo indietro. I fornitori dovranno inoltre garantire che i contenuti generati dall’intelligenza artificiale siano identificabili. Inoltre, il testo generato dall’intelligenza artificiale pubblicato con lo scopo di informare il pubblico su questioni di interesse pubblico deve essere etichettato come generato artificialmente. Ciò vale anche per i contenuti audio e video che costituiscono falsi profondi.

RISCHIO MINIMO O NULLO

L’AI Act consente l’uso gratuito dell’intelligenza artificiale a rischio minimo. Ciò include applicazioni come videogiochi abilitati all’IA o filtri antispam. La stragrande maggioranza dei sistemi di IA attualmente utilizzati nell’UE rientra in questa categoria.

COME FUNZIONA PER UN SISTEMA AD ALTO RISCHIO

Una volta che un sistema di intelligenza artificiale è sul mercato, le autorità sono responsabili della sorveglianza del mercato, gli operatori garantiscono la supervisione e il monitoraggio da parte delle persone e i fornitori dispongono di un sistema di monitoraggio post-commercializzazione. I fornitori e gli operatori segnaleranno anche incidenti gravi e malfunzionamenti.

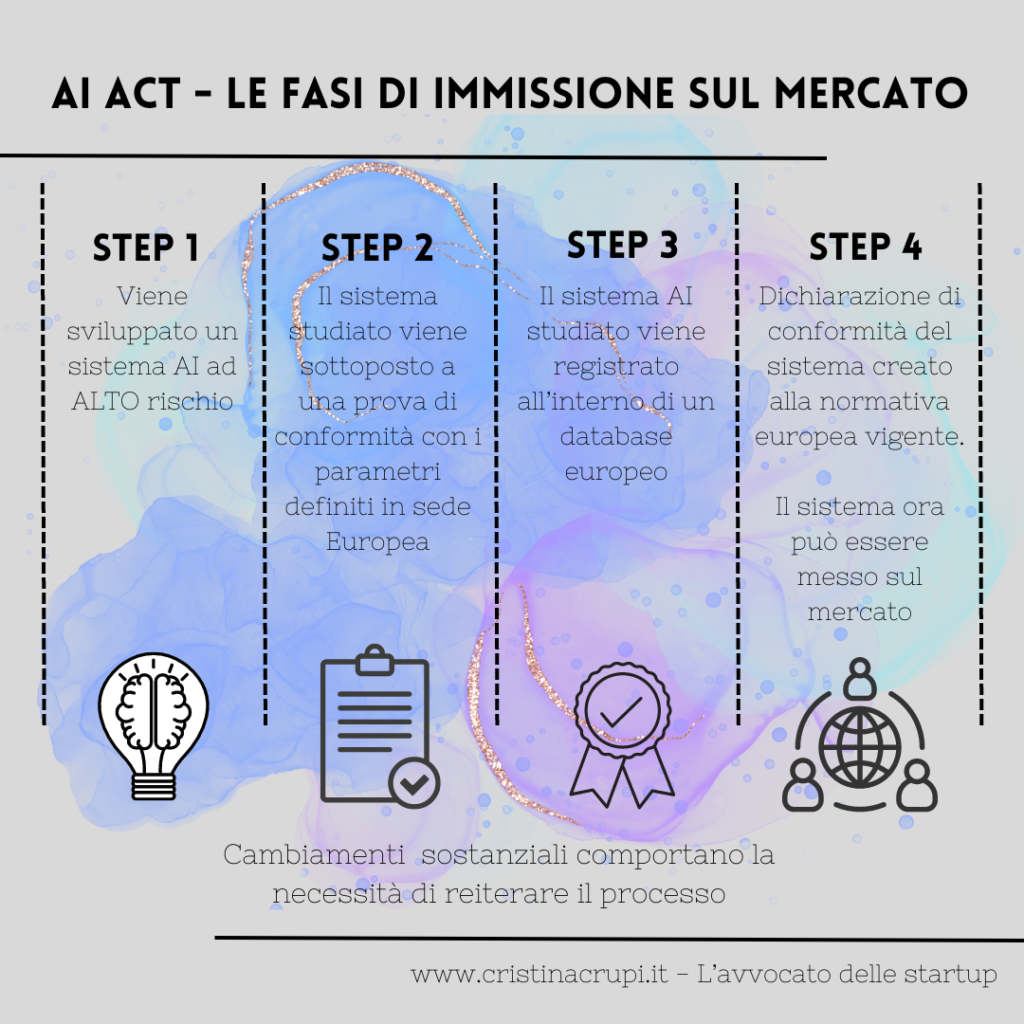

Lo schema procedurale per la immissione sul mercato di un sistema di AI complesso segue un ciclo reiterativo che vediamo nello schema riportato

AI ACT: UNA SOLUZIONE OPERATIVA PER I GRANDI MODELLI

Sempre più spesso, i modelli di intelligenza artificiale generica stanno diventando componenti dei sistemi di intelligenza artificiale. Questi modelli possono eseguire e adattare innumerevoli compiti diversi.

Sebbene i modelli di intelligenza artificiale generica possano consentire soluzioni di intelligenza artificiale migliori e più potenti, è difficile supervisionare tutte le funzionalità.

Lì, la legge sull’AI introduce obblighi di trasparenza per tutti i modelli di IA di carattere generale per consentire una migliore comprensione di questi modelli e ulteriori obblighi di gestione del rischio per i modelli molto capaci e di grande impatto. Questi obblighi aggiuntivi includono l’autovalutazione e la mitigazione dei rischi sistemici, la segnalazione di incidenti gravi, lo svolgimento di test e valutazioni di modelli, nonché i requisiti di sicurezza informatica.

UNA LEGISLAZIONE A PROVA DI FUTURO

Poiché l’intelligenza artificiale è una tecnologia in rapida evoluzione, la proposta ha un approccio a prova di futuro, consentendo alle norme di adattarsi ai cambiamenti tecnologici. Le applicazioni IA dovrebbero rimanere affidabili anche dopo essere state immesse sul mercato. Ciò richiede una gestione continua della qualità e del rischio da parte dei fornitori.

APPLICAZIONE E IMPLEMENTAZIONE DELL’AI ACT

L’Ufficio europeo sull’IA, istituito nel febbraio 2024 all’interno della Commissione, supervisiona l’applicazione e l’attuazione della legge sull’AI con gli Stati membri. Mira a creare un ambiente in cui le tecnologie di intelligenza artificiale rispettino la dignità umana, i diritti e la fiducia. Promuove inoltre la collaborazione, l’innovazione e la ricerca sull’intelligenza artificiale tra le varie parti interessate. Inoltre, si impegna nel dialogo e nella cooperazione internazionale sulle questioni relative all’IA, riconoscendo la necessità di un allineamento globale sulla governance dell’IA. Attraverso questi sforzi, l’Ufficio europeo per l’intelligenza artificiale si impegna a posizionare l’Europa come leader nello sviluppo etico e sostenibile delle tecnologie di intelligenza artificiale.

COSA SUCCEDE ADESSO

Nel dicembre 2023 il Parlamento europeo e il Consiglio dell’UE hanno raggiunto un accordo politico sulla legge sull’AI. Il testo è in fase di adozione formale e traduzione. La legge sull’IA entrerà in vigore 20 giorni dopo la sua pubblicazione sulla Gazzetta Ufficiale, e sarà pienamente applicabile 2 anni dopo, con alcune eccezioni: i divieti entreranno in vigore dopo sei mesi, le regole di governance e gli obblighi per i modelli di IA di carattere generale diventeranno applicabili dopo 12 mesi e le norme per i sistemi di IA, integrati nei prodotti regolamentati, si applicheranno dopo 36 mesi. Per facilitare la transizione al nuovo quadro normativo, la Commissione ha lanciato l’AI Pact, un’iniziativa volontaria che cerca di sostenere la futura attuazione e invita gli sviluppatori di IA provenienti dall’Europa e da altri paesi a conformarsi in anticipo agli obblighi chiave dell’AI Act.

L’immagine del presente articolo è di Markus Winkler.